Again CNN..

Review the report

지난 포스트에서 transfer learning을 이용하여 학습을 시켜보았는데

이번시간에는 transfer learning을 써야하는 이유에 대해서 다룬 논문을 리뷰해보겠습니다.

ABSTRACT

transfer learning이란 간단히 말해 기존의 네트워크를 가져와서 미세조정(fine-tuning)하여 새로운 problem solution을 찾는 것이다.

그러나, 기존의(source, original)네트워크가 타겟(target)네트워크가 dissimilar하다면 당연히 도움이 안될 것이라 생각한다.

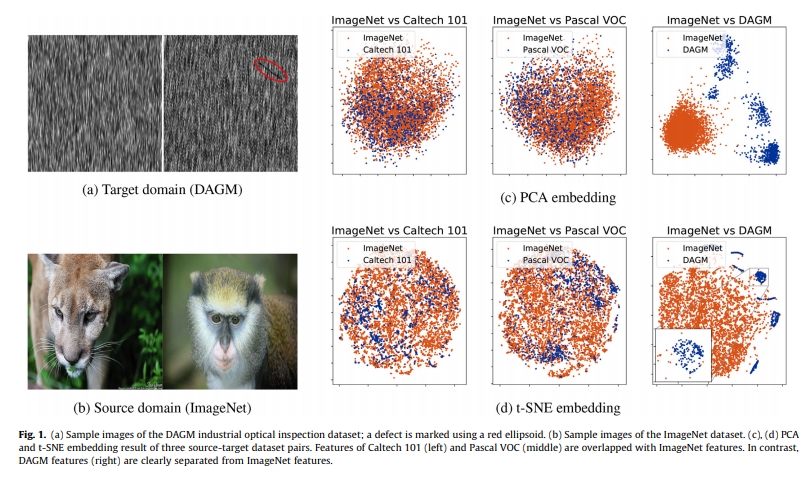

예를 들자면 ImageNet의 데이터들은 Caltech101이나 Pascal VOC의 데이터들과 similer하니까 학습하는 것이 비슷할 것이므로 transfer learning이 좋은 결과를 얻을 것이라고 누구나 예상할 수 있다.

그러나, ImageNet과 DAGM 데이터들은 PCA를 통해 distribution을 보면 확연히 다른 데이터들이므로 기존의 네트워크의 학습방법은 쓸모가 없을 것이라 생각한다.

하지만 실제로 transfer learning을 진행해본 결과 from-scratch로 학습한 네트워크보다 훨씬 좋은 효율(accuracy, # of parameters)을 가진다는 것이다.

Why Transfer Learning?

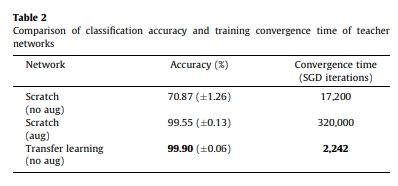

Comparison of classification accuracy and training convergence time of teacher networks

위의 표를 보면 결론적으로 data augmentation을 적용시킨 from-scratch 네트워크(99.55)도 transfer learning을 적용시킨 네트워크(99.90%)처럼 높은 정확도를 보여주고 있습니다. 하지만 Convergence Time을 보게 되면 약 1300배가량 더 많은 시간을 들여야 하는 것을 알 수 있습니다.